【FAQ】論文の学術的価値を損なわない範囲でのAI活用について

2025.11.17

2025.11.20

本FAQは、『第5回「論文関連業務の負担軽減」』の内容を補完し、読者が抱きやすい疑問に対してお答えするものです。 AIを活用した論文関連業務において、学術的価値を損なわないための判断基準や実践方法について整理いたします。

【用語定義】本FAQで使用する基本概念

このFAQを読む前に、次の用語をご理解いただくことで、より正確な解釈が可能になります。

- 「補助的活用」:著者または事務局が下した判断の根拠となる情報や表現を、AIに求めるもの。最終的な学術的判断は、人間が担う。

- 「不適切な活用」:AIが生成した内容をそのまま論文に用いるなど、著者の判断や検証プロセスを経ずに採用すること。

- 「透明性」:AIをどのような目的でどのように活用したか、を投稿時や出版時に明記すること。

I. 独創性・新規性を損なわないための活用とは?

Q1. AIで論文の構成案や執筆補助を受けると、著者の独創性が失われないでしょうか?

A1. ご指摘の懸念はもっともであり、ここがAI活用において最も重要な分岐点となります。

研究の核となる独創的な判断は、必ず著者が担うべき性格のものです。AIが活躍できる領域は「思考の整理」や「表現の洗練」に限定されるべきだと考えられています。将来的にはAI自身が「独創的な判断」をするような時代が来るかもしれませんが、まだまだ先のことです。

著者が担うべき独創的判断

・「何を調査するか」「どのような視点で分析するか」「結果をどう解釈するか」

AIが支援できる補助的活用

・『このキーワードで論文の構成案を作成してほしい』と依頼し、その案をたたき台とすること。既に執筆した原稿の英語翻訳や文法的な誤りの指摘を受けること

重要なのは、著者が自らの研究を深く理解し、AIを「思考の補助道具」として活用しているかという点です。 AIの提示した構成や内容をそのまま採用することは、著者の思考活動を外部化してしまい、独創性を失わせるリスクがあります。

【チェックリスト】独創性確保のための著者チェックリスト

- 論文の研究課題と仮説を、自分たちの言葉で説明できるか

- AIが提示した構成案のどこを自分たちが修正・改善したか、説明できるか

- 論文の結論は、自分たちの研究結果に基づいているか(AIの一般的な示唆ではないか)

【参考】

・Authorship and AI tools | COPE: Committee on Publication Ethics

・Academic Writing and AI: Do’s and Don’ts for Researchers | Editage Insights

・Evolving journal guidelines for use of AI | Editage Insights

Q2. 参考文献をAIで検索・生成してもらう場合、学術的信頼性に問題はないでしょうか?

A2. AIのハルシネーション(hallucination:幻覚)に注意し、参考文献は必ず著者が元文献を確認・検証することが必須です。

参考文献は論文の学術的根拠であり、その正確性は著者の信頼性に直結します。AIには、実在しない論文や著者を「創作」してしまう場合があるため、完全に依存することは避けるべきです。 AIを補助ツールとして活用する余地はありますが、次の検証プロセスが不可欠です。

有用な補助活用例

- 既知の参考文献リストを入力し、引用形式を統一させる

- 『この分野の重要な研究は他にないか』と質問し、提示された文献を著者が実際に内容を確認した上で引用する

- 特に新規性を担保するためには、国内だけでなく諸外国の文献や論文に広くあたる必要があります

医学分野の論文発表数は年間で100万本とも云われます。この数を人間の力で読みこなすのは不可能です。 気を付けたいのは、AIが提示した参考文献について、著者が必ず元文献にあたり、その存在と内容の正確性を検証するプロセスを経ることです。 この検証を経ることで、学術的信頼性が担保されます。

【Tips】参考文献の信頼性確保のプロセス

ステップ1:AIに提示された文献について、DOIやPubMed IDで検索し、実在を確認

ステップ2:実在が確認できた文献のみ、本論文に引用

ステップ3:引用形式と内容が一致しているかを最終確認

【参考】

・Evolving journal guidelines for use of AI | Editage Insights

・Authorship and AI tools | COPE: Committee on Publication Ethics

・Science & Engineering Indicators | NSF(米国科学財団)

II. 正確性・再現性を担保するための活用方法は?

Q3. 研究方法や統計手法の説明をAIに整理してもらっても大丈夫でしょうか?

A3. 「表現の整理」という目的であれば概ね問題ありませんが、「何が重要な情報か」という判断は著者が行う必要があります。

研究の再現性は学術論文の根本原則であり、読者が同じ方法で同じ実験を行えるだけの詳細さと正確性が求められます。このプロセスで著者の判断が疎かになると、再現性は失われてしまいます。

有効な活用例

- 著者が作成した「研究方法」の章をAIに読ませ、『この説明で不足している部分や、より明確にできる表現がないか』と質問する

- AIに文法的な誤りや論理的な流れの不明確さを指摘させる

一方、「何が重要な情報か」「どのレベルの詳細が必要か」といった判断は、その研究分野の専門家である著者が行うべきでしょう。 統計手法についても、AIに「結果の解釈」を委ねることは避けるのが賢明です。

著者が「自分の研究を深く理解した上で、表現の改善や論理的な流れの確認にAIを活用する」というスタンスを保つことで、正確性と再現性の維持が実現されます。

【Tips】方法セクションのAI活用の目安

✓ 可能:文法の確認、表現の改善、流れの確認

✓ 要確認:統計手法の説明の適切性

✗ 不可:統計結果の解釈、手法の選択理由

【参考】

・Academic Writing and AI: Do’s and Don’ts for Researchers | Editage Insights

・Best Practices for Using AI Tools as an Author, Peer Reviewer, or Editor | PMC

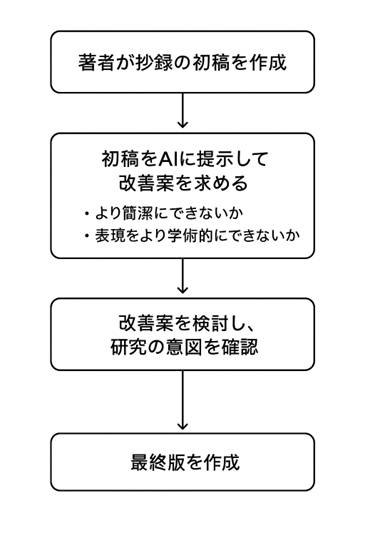

Q4. 抄録や要旨の作成をAIに任せても問題ないでしょうか?

A4. 抄録はその論文の「顔」であり、AIに完全に任せるのではなく、著者による最終判断を必ず経るべき部分です。

AIは、著者が執筆した日本語の抄録を英語に翻訳したり、長さを調整したり、表現を洗練させたりすることが得意です。こうした補助的な活用は抄録の品質向上につながります。

ただし、「論文の重要な部分は何か」「どのような表現で伝えるべきか」といった学術的な判断は、著者にしかできません。 AIが生成した抄録は、その著者の研究に対する認識とズレが生じる可能性があるからです。

理想的な活用フローは、まず著者が初稿を作成し、次にその初稿をAIに提示して改善案を求め、最終的に著者が確認・検討した上で最終版を作成するプロセスです。 このフローであれば、抄録の正確性と品質の両立が実現できます。

【Tips】抄録作成時のAI活用フロー

- 著者が研究の要点を150~250語で執筆

- AIにチェック依頼:「重複表現はないか」「冗長な部分はないか」

- AIの改善案を確認し、著者が承認・修正

- 修正版について、分野の共同研究者に読んでもらい、意図が伝わるか確認

※AIによる抄録作成プロセス(ChatGPTによる作画)

【参考】

・Evolving journal guidelines for use of AI | Editage Insights

・Authorship and AI tools | COPE: Committee on Publication Ethics

III. 責任と透明性を維持するための活用について

Q5. AIを使用した場合、投稿時にその旨を報告する義務はあるのでしょうか?

A5. 出版倫理の国際基準では透明性が原則とされています。

各学会の投稿規定に明記された基準に従うことが、最も適切な対応です。COPE(Committee on Publication Ethics:出版倫理委員会)などの国際基準では、AIは責任を取ることができないため「著者」にはなれないとされています。同時に、補助的な活用自体は否定されておらず、「透明性を持って、AIをどのように活用したかを明記する」という積極的な立場が一般的です。

学会として先手を打つなら、投稿規定に次のような文言を追加することが望ましいでしょう。

「AIツールを使用した場合は、その旨と使用方法を投稿時に申告してください。AIが著者になることはできませんが、適切に活用された場合は投稿を受け付けます。」

こうした明確な指針があれば、投稿者も安心して、かつ責任を持ってAIを活用できるようになり、査読の段階でAI使用の適切性の判断がしやすくなります。

【チェックリスト】投稿規定に記載すべきAI使用に関する項目

- AI使用の報告義務(「使用した場合は申告してください」等)

- 推奨される活用範囲(文法確認、翻訳補助等)

- 禁止される活用方法(結果の自動生成、全文生成等)

- 著者の責任について(「著者がAI出力の正確性を確認する責任がある」等)

【参考】

・Authorship and AI tools | COPE: Committee on Publication Ethics

・雑誌論文・記事作成時の生成AI使用に関するお願い | 医学書院

・Artificial intelligence and authorship | COPE: Committee on Publication Ethics

Q6. 査読プロセスにAIを導入する場合、気をつけるべき点は何でしょうか?

A6. 査読の機密性と専門家による判断を損なわないことが、気をつける点です。

査読は論文の学術的価値を判定する最も重要なプロセスであり、AIは査読そのものの判断を補助する限定的な役割に徹すべきとされています。

事務局レベルでの有用な活用例

- 投稿論文の技術的なチェック(文法、参考文献の形式など)

- 査読者の負担を軽減するための初期スクリーニング(キーワード分類による査読者のマッチング最適化)

一方、研究内容の学術的価値や独創性、方法論の妥当性といった本質的な評価判断は、専門家である人間の査読者に委ねるべきです。

特に、査読プロセスにおいて個人情報やセンシティブな研究情報を扱う場合、AIツールの利用に際しては、データ保護とセキュリティに特別な配慮が必要です。

学会として事前に利用規約を確認し、情報管理の方針を定めておくことが大事です。

【Tips】査読プロセスのセキュリティ確保

✓ 技術的チェック(文法、参考文献形式等)のみAI活用

✗ 査読者の個人情報やコメント内容をAIに入力しない

✗ 著者の氏名や所属などのセンシティブ情報を外部AIツールに入力しない

→ 学会内部システムでAI処理を行う、または「学習しない」設定のAIツールを選定

【参考】

・Artificial intelligence and peer review | COPE: Committee on Publication Ethics

・Ethical guidelines for peer reviewers | COPE: Committee on Publication Ethics

・Best Practice Guidelines on Publishing Ethics | Wiley

Q7. AI検出ツールを使って、AIが生成した不正な論文を見つけられるでしょうか?

A7. 現在のAI検出ツールの精度や信頼性にはまだ課題が残っています。

むしろ、透明性とガイドラインの整備の方が効果的です。

現在、AIテキストの検出ツールが複数存在しますが、その精度と信頼性については、学術的な検証がまだ充分ではありません。 完全に人間が執筆したテキストでも「AI生成と判定される」といった偽陽性の課題も報告されています。

学会として取りうる、より実質的な対応は、AI活用に関する透明性と明確なガイドラインの整備です。 投稿者が「AI活用の方針」を理解し、それに従った行動をする環境を作ることが、検出ツールの導入よりも学術的信頼性の維持につながります。

ただし、学会規模や分野特性によっては、検出ツールの価値を検討する余地があります。 導入する場合は、複数のツールを組み合わせる、検出結果の解釈を人間の専門家が行うなど、多層的なアプローチを採用することが求められます。

【Tips】AI検出ツールの限界と透明性の重要性

→ 検出ツールに100%の信頼は禁物

→ 「AIを使用した場合は申告」という透明性が最も有効

→ 複数のツールの結果が一致した場合のみ、さらに詳細調査を実施

【参考】

・Authorship and AI tools | COPE: Committee on Publication Ethics

・Reviewer suspects use of AI by an author | COPE: Committee on Publication Ethics

・偽陽性と偽陰性:2種類の過誤 | AIコンパス

IV. 利益相反をチェックして公正性を確保する機能

Q8. AIを使用することで、利益相反や公正性に新たな問題が生じないでしょうか?

A8. ご指摘の通り、AIの活用に伴い、出版倫理における新しい論点が生じています。

学会として、機密情報の漏洩を防ぐための方針整備が事前に必要です。AIツールの多くは、ユーザーの入力情報(プロンプト)を今後のAIトレーニングに活用する仕様になっています。

そのため、著者が機密情報や未発表の研究内容をAIに入力した場合、情報が外部に漏えいするリスクが存在します。 これは、利益相反や企業秘密の観点から大きな懸念事項です。

学会として投稿者に対しては、

「機密情報や未発表研究の詳細をAIツールに入力しないよう注意喚起する」

といったガイダンスが不可欠です。 また、AIが生成した画像やテキストの著作権帰属についても明確にしておく必要があります。 多くのジャーナルでは、「AIが生成した画像は、それが学術的に正当化されない限り、論文への使用は推奨されない」としています。

【Tips】AIツール使用時の機密情報管理

✗ 未発表の研究データ、実験結果

✗ 産業秘密に関わる情報

✗ 共同研究機関との契約に基づく機密情報

✓ 公開済みの学術文献の参考文献形式や表現の確認

【参考】

・Authorship and AI tools | COPE: Committee on Publication Ethics

・Artificial intelligence (AI) in decision making | COPE: Committee on Publication Ethics

・Best Practice Guidelines on Publishing Ethics | Wiley

・Artificial Intelligence (AI) | Springer Nature

Q9. AIツールの選定や導入にあたって、学会として何を確認すべきでしょうか?

A9. セキュリティとプライバシー、そして学会の価値観との合致が、導入判断の重要な基準になります。

学会がAIツールを導入する際(例:参加者対応のチャットボットなど)に確認すべき主な項目は次の通りです。

- データ保護とプライバシー:ユーザーが入力した情報がどのように管理され、トレーニングデータとして利用されないかを確認します。

- 透明性と説明可能性:AIツールの判断やフィルタリングの基準が、学会の関係者に説明できるものであるかを検討します。

- 学会のポリシーとの整合性:学会の理念や学術的価値観と、AIツールの機能や利用規約が矛盾していないか吟味します。

- 継続的な管理体制:不具合が生じた場合の対応、AIの出力結果の定期的な監査などが、学会内で体系的に行われる体制があるか確認します。特に、月次の出力品質監査、四半期ごとのセキュリティ監査、年次のポリシー見直しなどを検討してください。

これらの確認を経ることで、学会のAI導入が、参加者と学会の双方に価値をもたらすようになります。

【チェックリスト】 AIツール導入前のチェックリスト

- ベンダーのセキュリティ認証(ISO27001等)の確認

- 利用規約に「データが学習に使用されない」条項があるか

- 定期的なセキュリティ監査の実施体制

- 導入後の運用担当者の決定

- 代替ツール候補の事前検討

- 3ヶ月後の評価予定日の設定

【参考】

・COPE Focus on artificial intelligence | COPE: Committee on Publication Ethics

・Best Practice Guidelines on Publishing Ethics | Wiley

Q10. 小規模な学会ですが、AI活用ガイドラインを整備する必要があるでしょうか?

A10. ご質問はもっともです。

規模を問わず、事前の方針整備が学会の信頼性と社会的ポジションの向上に役立ちます。 小規模な学会であっても、投稿者や参加者がAIを使用する可能性は十分にあります。

そのため、投稿規定に「AIを使用した場合は申告してください」という一行を追加するだけでも、透明性と信頼性が大幅に向上します。

小規模学会の利点である「投稿者と直接対話しやすい」という点を活かし、個別の相談に丁寧に応じながら、学会のAI活用ガイドラインを成長させていくというアプローチも有効です。

【Tips】小規模学会向けの段階的ガイドライン整備

フェーズ1(即座):投稿規定にAI申告条項を追加

・投稿規定の「その他」セクションに、AI使用報告義務について1~2文追加

フェーズ2(1~2ヶ月):投稿者向けの簡潔なAI活用ガイドを作成

・A4用紙1~2枚の「Q&A形式」で、よくある質問に回答

・具体例を含める(例:「翻訳補助はOK、結果の自動生成はNG」)

フェーズ3(3~6ヶ月):査読者向けのAI対応ガイドを作成

・査読時にAI使用の適切性をチェックするためのポイント整理

・不適切な使用の具体例を提示

フェーズ4(以降):学会の活動内容に応じて事務局スタッフ向けのAI導入ガイドを検討

・必要に応じて、チャットボットや自動返信システムの導入基準を整備

【参考】

・COPE: Promoting integrity in scholarly research and its publication | COPE

V. 導入後の実装課題と対応

Q11. AI活用ガイドライン導入後、投稿者から「AIの使用範囲が曖昧」との質問を受けました。どう対応すればよいでしょうか?

A11. よくある課題です。個別対応と情報発信のバランスが大切です。

段階的な対応方法:

ステップ1:個別相談への丁寧な対応

投稿者からの問い合わせに対しては、「判断の基準」を明確に説明してください。前述の「用語定義」セクションで示した「補助的活用」と「不適切な活用」の区別を用いると、具体的に説明しやすくなります。

例えば、「AIに論文全体を要約させて、そのまま使用する」のはNGですが、「自分が執筆した要約をAIに編集してもらう」はOKという具合に説明できます。

ステップ2:よくある質問(FAQ)の学会ウェブサイトへの公開

投稿者からの問い合わせが共通のテーマを示していれば、それを学会FAQセクションに追加してください。「投稿者からよくいただく質問」という形式で公開すると、他の投稿者にも参考になり、問い合わせ件数の軽減につながります。

ステップ3:投稿者向けのオンライン講習会やウェビナーの開催

半年に1回程度、「AI活用ガイドの具体例説明」というテーマで、オンラインの簡短なウェビナー(30分程度)を開催するのも有効です。著者からの事前質問を募集し、講習会で直接回答することで、理解が深まります。

ステップ4:ガイドラインの改訂

投稿者からの質問内容を分析し、「曖昧だった点」が明らかになれば、次のガイドライン改訂時に、より具体的な表現に修正してください。例えば「表現の改善がOK」ではなく、「単語の言い換えや文体の統一といった表現の改善がOK」といった具体例を加えると、理解が容易になります。

【チェックリスト】曖昧さを減らすための実装工夫

- 「補助的活用」と「不適切な活用」の具体例を5件以上、用意する

- 学会ウェブサイトの投稿ページに、よくある質問コーナーを設置

- 月1回程度、問い合わせ内容をスタッフ間で共有し、パターン化する

- 実装3ヶ月後に、ガイドラインの見直しを計画する

Q12. 査読者がAIを不適切に活用した疑いがある場合、どのように対処すべきでしょうか?

A12. 落ち着いた対応と段階的な確認が大切です。

安易な「非難」は避け、事実確認と対話を重視してください。AIを活用する査読者が増えるにつれ、AIの不適切な使用を疑うケースが生じる可能性があります。ここで重要なのは、「疑い」だけで判断せず、客観的な確認プロセスを経ることです。投稿者との関係性を重視し建設的な議論に発展させることがポイントです。

段階的な対応フロー:

ステップ1:査読内容の詳細な確認

査読者の意見が以下のいずれかに該当するかを確認してください。

- 著者の研究内容を誤解・無視した指摘が複数ある

- 専門分野に関する基本的な理解が不足している

- 一般的な教科書的回答に終始している

これらは必ずしもAI使用を示唆するものではなく、査読者の不注意や準備不足の場合もあります。

ステップ2:著者との対話と確認

著者に「この指摘についてはどう考えますか」と質問し、著者の見解を聞くことで、査読コメントの妥当性を客観的に判断する材料が得られます。

ステップ3:査読者への丁寧な確認

疑わしい点があれば、査読者に対して懐疑的ではなく、確認的な態度で問い合わせてください。例えば、「このご指摘についてはAIツールを活用されたのでしょうか。もしそうであれば、当学会のガイドラインに照らして確認させていただきたく、その旨をお知らせいただけますでしょうか」といったようなトーンが適切です。

多くの場合、査読者は誠実に対応してくれます。査読者がAIを使用したとしても、その使用が適切な範囲内(例:英文チェック)であれば、それ自体は問題になりません。

ステップ4:学会内での事例共有

確認の結果、AIの不適切な活用が確実になった場合は、その事例を(個人名や論文を特定しない形で)学会内部のスタッフ間で共有し、今後の判断基準の参考にしてください。

ステップ5:査読者への注意喚起

不適切な活用が複数回確認された査読者に対しては、個別に「ガイドラインの確認」をお願いすることが妥当です。この段階でも、相手を尊重し、教育的なアプローチを心がけてください。

【Tips】査読プロセスでのAI不正活用の兆候

- 著者の特殊な研究手法や状況設定を無視した指摘

- 当分野では一般的でない用語を使用した指摘

- 査読者の専門分野を明らかに外れた深い技術的コメント

- 極めて定型的で、実際の論文内容を反映していないコメント

留意事項: 上記のいずれかに該当しても、必ずしもAI使用を意味するわけではありません。査読者の不注意や準備不足、あるいは当該分野における専門知識の差異が原因である場合も多いため、段階的な確認と対話を重視してください。

【参考】

・Artificial intelligence and peer review | COPE: Committee on Publication Ethics

・Ethical guidelines for peer reviewers | COPE: Committee on Publication Ethics

まとめ AIは「方法」であり「責任は著者にある」

本FAQで述べたように、論文関連業務におけるAIの活用は、学会の質向上と投稿者の負担軽減の両面において大きな可能性を秘めています。一方で、学術的価値や倫理的規範を損なわないためには、慎重かつ透明性のある判断が不可欠です。

根本的な原則は、「AIは手段であり目的ではない」という点にあります。AIは著者の思考を代替するものではなく、判断と責任を支援する道具として機能すべきです。

表現の改善、論理構成の確認、膨大な文献からの情報抽出など、補助的な役割に徹することで初めて、学術論文の価値向上に寄与します。

学会事務局が投稿者と対話を重ねながら、学術的価値を維持するためのAI活用のあり方を共に模索する姿勢は、学術コミュニティの信頼と持続的な発展に資するものです。

技術は日々進化しており、「AIを適切に活用するとは何か」という問いを継続的に再考し、その時々の最善の在り方を探求する営みの中にこそ、論文の信頼性と学会の社会的意義が育まれます。

また、本FAQが想定していない新しい課題や事例が生じた場合は、国際的な出版倫理の動向を注視しながら、適宜ガイドラインを更新していくことが肝心です。具体的には、COPEのWebサイトやEditage等の学術出版情報サイトを定期的に確認し、最新の知見を学会内に共有する体制を整えることで、常に適切な判断基準を保つことができます。

【参考】

・Committee on Publication Ethics | COPE

・Editage Insights|Editage

・人工知能学会 | The Japanese Society for Artificial Intelligence

学術大会・国際会議開催システム「アワード」のご紹介

学会運営における課題を解決し、効率的かつ効果的な運営を実現するために、学術大会・国際会議開催システム「アワード」は以下のニーズにお応えします。

-

1. 学会の効率化と人手不足の解消

学会運営では、事務局の業務量が膨大で、少人数で対応するのが難しい場合もあります。学術大会・国際会議開催システム「アワード」は、煩雑な運営業務を自動化・効率化することで、人的リソースの負担を軽減します。たとえば、参加登録、プログラム作成、講演者管理などがワンストップで完結します。

-

2. 学会運営のコスト削減

学会開催には、印刷物や郵送、事務局人件費など多くのコストが発生します。学術大会・国際会議開催システム「アワード」は、クラウドベースでの運営によりこれらのコストを大幅に削減可能。さらに、事務局代行費用を削減しつつ、高品質なサービスを提供します。

-

3. 決済機能でスムーズな収益管理

学会参加費や年会費のオンライン決済に対応。安全性の高い決済システムを導入しているため、事務局での入金確認の手間が省け、効率的な資金管理が可能です。これにより、参加者にも事務局にもストレスフリーな学会運営を実現します。

-

4. 学会運営サポートで「大変」を「簡単」に

「学会運営が大変」と感じている学会事務局の方々に向け、運営全般を支援する学会運営サポートをご用意しています。例えば、会場手配、プログラム編成、スポンサー管理など、運営代行サービスもご紹介可能です。

-

5. 柔軟な管理システムで多様なニーズに対応

学術大会・国際会議開催システム「アワード」は、学会の規模や形式に応じて柔軟にカスタマイズ可能。オンライン学会、ハイブリッド開催にも対応しており、参加者がどこにいても円滑な学会開催をサポートします。

-

6. 費用対効果の高い学会開催を実現

学会開催費用を抑えつつ、質の高い学会運営を目指す方に最適なソリューションです。クラウド型システムの導入で初期費用を抑え、必要に応じて追加オプションを選択することが可能です。

学術大会・国際会議開催システム「アワード」は、学会の運営をトータルでサポートし、効率化・コスト削減を実現する強力なパートナーです。学会運営の課題を抱える事務局や運営会社の皆さま、ぜひ一度ご相談ください!